LE MONDE AVRIL 2018

8888888888888888888888888888888888888888888888888

1

L'intelligence artificielle repère les ondes

gravitationnelles

01 mai 2018

Artificial intelligence spots gravitational waves

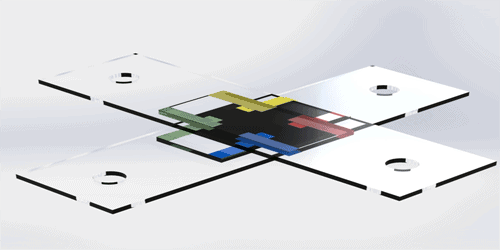

Fusion de trous noirs simulée

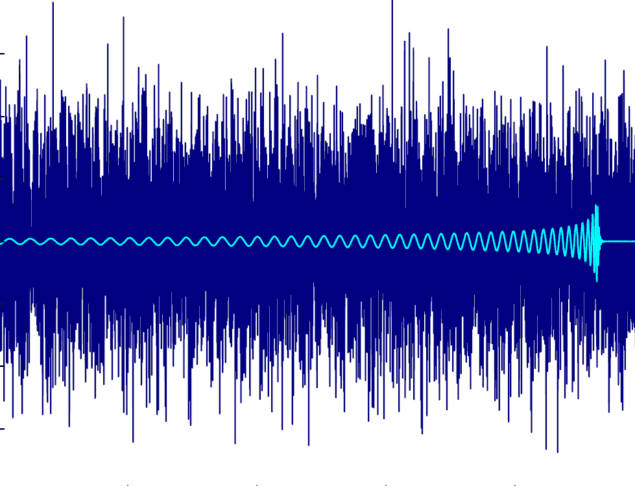

Faux bruit: signal simulé provenant d'une fusion de trous

noirs binaire qui a été intégrée dans le bruit (Courtoisie: H. Gabbard et al.,

Phys. Rev. Lett.)

Un système d'apprentissage en profondeur capable de filtrer

les signaux d'ondes gravitationnelles à partir du bruit de fond a été créé par

des physiciens britanniques. L'apprentissage profond reposse sur une technique

de reconnaissance de formes inspirée par les neurones qui a déjà été appliquée

au traitement d'images, à la reconnaissance de la parole et aux diagnostics

médicaux, entre autres choses. Chris Messenger et ses collègues de l'Université

de Glasgow ont montré que leur système est aussi efficace que le traitement de

signal conventionnel et qu'il a le potentiel pour identifier les signaux

gravitationnels beaucoup plus rapidement.

Les ondes gravitationnelles sont des ondulations dans

l'espace-temps que l'on peut observer avec les détecteurs LIGO-Virgo, qui sont

des interféromètres laser avec des paires de bras de plusieurs kilomètres

positionnés à angle droit l'un par rapport à l'autre. Quand une onde passe à travers la Terre, elle étire très légèrement

un bras tout en restreignant l'autre,

avant de presser le premier et d'étirer le second, et ainsi de suite. Cela

génère une série d'oscillations minuscules mais distinctes qui sont

enregistrées comme des variations dans les modèles d'interférence mesurés par

les instruments.

La première onde gravitationnelle détectée a été captée par

les deux détecteurs LIGO aux États-Unis en septembre 2015. Contrairement aux

signaux observés depuis, ces oscillations étaient visibles à l'œil nu dans les

données brutes. Normalement, les signaux d'ondes gravitationnelles sont

submergés par le bruit - sismique, mouvement thermique ou statistiques de

photons - qui doivent être filtrés à l'aide d'algorithmes informatiques pour

que le signal doive émerger.

Habituellement, les signaux sont sélectionnés à partir du

bruit en utilisant une technique connue sous le nom de filtrage adapté. Cela

implique de comparer les oscillations enregistrées par l'interféromètre avec

une série de modèles représentant des formes d'onde produites par différents

événements astrophysiques qui sont calculés en utilisant des équations

post-newtoniennes et relativistes. Une correspondance significative entre les

données d'observation et l'un des modèles signifie une détection vraie , tandis

que le type de forme d'onde dans le modèle révèle ce qui a provoqué l'onde

gravitationnelle en question.

Cependant, la nécessité de comparer un grand nombre de modèles

pour assurer un résultat précis signifie que le filtrage adapté nécessite

beaucoup de puissance de traitement et prend du temps. Dans son dernier travail, l'équipe a montré qu'ils

peuvent potentiellement réduire le temps nécessaire - en utilisant l'apprentissage

automatique plutôt que des algorithmes conventionnels. Leur système repose sur

un réseau neuronal qui, comme le cerveau, est constitué de couches d'unités de

traitement qui se déclenchent lorsqu'elles reçoivent une certaine entrée.

La couche d'entrée du système d’apprentissage contient les

données brutes qui proviendraient d'un interféromètre – c est à dire une série de nombres liés aux variations de la

tension des bras. Ces données sont transmises à la première des neuf couches

internes composées de neurones dont la sortie dépend des données d'entrée et

d'une pondération appliquée à chaque neurone. Avec ces sorties formant alors

les entrées de la couche suivante, et ainsi de suite, le système se termine par

une couche finale composée de seulement deux neurones qui génèrent chacun une

valeur de probabilité entre 0 et 1. Un neurone révèle la probabilité que les

données brutes contient un signal effectif tandis que l'autre, inversement,

décrit la probabilité qu'il ne contienne que du bru

Initialement, les poids des neurones sont fixés de manière

aléatoire et le système est «formé» en l'exposant à une série d'échantillons de

données, dont la moitié est constituée d'un signal d'onde gravitationnelle

provenant de fusions binaires noires couvertes par le bruit gaussien. l'autre

moitié contient uniquement du bruit gaussien. Les valeurs de probabilité

calculées par le système dans chaque cas sont comparées au type de données

(connu) - signal ou bruit - et le degré d'erreur est ensuite utilisé pour ajuster

les poids de neurones couche par couche dans un processus appelé propagation

arrière. L'idée est que, après suffisamment d'itérations, le réseau peut

distinguer le signal du bruit de façon fiable.

Après avoir initialisé leur système avec un demi-million de données,

Messenger et ses collègues l'ont ensuite alimenté de 20 000 nouvelles formes

d'onde pour voir combien il pouvait en identifier correctement. Ils ont également

analysé le même ensemble de formes d'onde en utilisant un filtrage adapté. Ils ont

constaté que les deux techniques se comportaient de manière presque égale -

leur capacité à trouver les signaux enterrés dépendant de manière très

similaire du rapport signal / bruit et de la probabilité de confondre le bruit

avec le signal. Cependant, parce que la majeure partie du calcul pour

l'apprentissage en profondeur se produit pendant l'entraînement, la nouvelle

technique était beaucoup plus rapide - en prenant seulement quelques secondes

pour analyser toutes les formes d'onde inconnues plutôt que plusieurs heures.

Selon Hunter Gabbard, membre du groupe de Glasgow, cette

vitesse plus élevée pourrait s'avérer utile à mesure que les interféromètres

deviennent plus sensibles et détectent plus souvent les ondes

gravitationnelles. Cela, dit-il, pourrait aider les astronomes à alerter plus

vite des signaux de la fusion des étoiles à neutrons

afin qu'ils puissent déjà orienter leurs

télescopes vers le satellite.

Traitant le ciel en

question et capter le rayonnement électromagnétique qui l'accompagne avant

qu'il ne disparaisse.

Le groupe de Glasgow

n'est cependant pas le seul à avoir appliqué l'intelligence artificielle à la

détection des ondes gravitationnelles. En particulier, Daniel George et Eliu

Huerta de l'Université de l'Illinois aux États-Unis ont déjà publié deux

articles montrant que l'apprentissage en profondeur peut fonctionner plus

rapidement que le filtrage adapté. Ils ont également utilisé leur réseau

neuronal pour estimer les propriétés des signaux d'ondes gravitationnelles,

tels que les masses de trous noirs rayonnants, ainsi que pour analyser des

données LIGO réelles, par opposition à des simulations. Ces données,

soulignent-ils, peuvent contenir ce que l'on appelle des parasites - un bruit

qui peut imiter un signal - ainsi qu'un bruit purement gaussien.

Rory Smith de

l'Université Monash en Australie est légèrement plus prudent quant au potentiel

d'apprentissage en profondeur. Il dit qu'il «pourrait un jour être prometteur»,

suggérant que cela pourrait s'avérer particulièrement utile pour distinguer les

signaux astrophysiques des pépins, mais préfère développer des approches

«basées sur des principes» plus basées sur la physique. "Il y a encore

beaucoup de place pour mieux comprendre les signaux et les données que nous

avons sans avoir à recourir aux

techniques de la boîte noire", argumente-t-il. Messenger et ses collègues

décrivent leur travail dans Physical Review Letters

. Edwin Cartlidge est un écrivain scientifique basé à Rome

MON COMMENTAIRE /Il apparait que ce travail a déjà été mené aux USA …Je veux bien

croire qu’il soit utile de le

doubler mais actuellement c’est la mode de promouvoir l’usage de l’intelligence

artificielle a toutes les sauces !!

J’aimerais plutôt qu’ on m’assure que

cette méthode permet de s’attaquer à des trains d’ondes gravitationnelles

d’évènements encore plus petits ou plus

anciens ou plus lointains …..Regardez

sur le signal brut à quel point le passage de l’onde est camouflé !!!

88888888888888888888888888888888888888888888888888888888888888

2

Surface phonon polaritons boost heat transfer

Les polaritons de phonons de surface accélèrent le transfert

de chaleur

01 mai 2018 Hamish Johnsto

Keunhan Park et ses collègues de l'Université de l'Utah et

de l'Université de Pittsburgh aux Etats-Unis ont découvert de nouvelles idées

sur le renforcement du transfert de chaleur entre les objets lors de très

courtes séparations. L'équipe a fait des mesures extrêmement précises de la

façon dont la chaleur se déplace entre deux plaques de quartz séparées par une

distance de 200 nm. Ils ont constaté que le transfert d'énergie est augmenté

d'environ 45 fois à des séparations minuscules, ce qu'ils attribuent au

couplage des polaritons de photons de surface à travers l'espace entre les

plaques.

Normalement, le transfert de chaleur entre deux objets à des

températures différentes peut être approximé en supposant que les objets sont

des "corps noirs". Ce sont des entités idéales qui absorbent tous les

radiations qui tombent sur eux et émettent un rayonnement thermique selon la

loi de Planck. Les physiciens savent depuis quelque temps que cela se décompose

lorsque les objets se trouvent à quelques centaines de nanomètres l'un de

l'autre, où ils s'échangent la chaleur beaucoup plus rapidement que ne le

laissait supposer l'approximation du corps noir. En effet, cette amélioration

«en champ proche» a déjà été utilisée dans certaines technologies incluant

l'extraction de chaleur et les systèmes thermo photovoltaïques.

Cependant, une utilisation plus répandue de la mise en

valeur a été entravée par une mauvaise compréhension de l'effet - qui est le

résultat de difficultés expérimentales significatives dans la mesure du

transfert de chaleur entre des objets séparés de seulement quelques centaines

de nanomètres. Ces défis comprennent le contrôle du flux de chaleur indésirable

et un contrôle précis de l'orientation et de la séparation des deux objets

Park et ses collègues

ont mesuré le transfert de chaleur radiatif entre deux plaques macroscopiques

de quartz mesurant chacune 5 × 5 mm et séparées par une distance qui pourrait varier

entre 200 et 1200 nm. Une caractéristique clé de leur appareil expérimental est

qu'ils peuvent maintenir les plaques parallèles à l'intérieur d'une fraction de

milli degré. En effet, en faisant varier l'angle entre les plaques, ils ont pu

montrer que le transfert de chaleur est extrêmement sensible à la façon dont

les plaques sont parallèles - chute de 5% lorsque les plaques sont désalignées

de seulement 3 millièmes de degré

En plus de confirmer que le transfert de chaleur par

rayonnement est amélioré sur de courtes distances, les expériences suggèrent

que les polaritons de phonons de surface sont responsables de la poussée. Les

phonons sont des excitations acoustiques ressemblant à des particules qui se

produisent dans les solides. Le quartz est un cristal polaire et cela signifie

que ses phonons peuvent générer des champs électriques oscillants. Ces champs

peuvent se coupler avec des photons à la surface du quartz pour créer des

polaritons de phonons de surface, qui sont des excitations de type photon. Les

mesures révèlent que le transfert de chaleur est proportionnel à un sur le

carré de la séparation entre les plaques, ce qui concorde avec les calculs

théoriques de la façon dont l'énergie est transférée à travers l'espace par les

polaritons de plasmons de surface.

En écrivant ceci dans

Physical Review Letters, l'équipe dit que leur technique pourrait être utilisée

pour mesurer les propriétés de rayonnement thermique en champ proche d'une

gamme de matériaux et de structures différents.

Hamish Johnston est l'éditeur de physique générale de

Physics World

MON COMMENTAIRE / je m’étonne de l’absence de toute convection thermique ou de l’effet thermique des particules adsorbées ou se désorbant sur le quartz

8888888888888888888888888888888888888888888888888888888888888

3

Laser bioprints stem cells

Cellules souches de bioprints laser

27 avr. 2018 Belle Dumé

En Allemagne, des chercheurs ont réussi à imprimer pour la

première fois un type spécial de cellules souches - les cellules souches

pluripotentes dites humaines (hiPSC). Ces hiPSC sont appréciées pour leur

capacité à se différencier en n'importe quel type de cellule humaine, une

propriété appelée pluripotence, de plus

elles peuvent être générées à partir des propres cellules du patient pour

éviter le risque d'une réponse immunitaire lorsqu'elles sont implantées dans le

corps.

En conséquence, de nombreux scientifiques croient que les

hiPSC imprimés offrent la meilleure option pour la fabrication d'organes de

remplacement ou d'organes sur puce pour des tests personnalisés de médicaments.

Le problème est que ces cellules sont notoirement fragiles et difficiles à

manipuler, surtout lorsqu'elles sont dissociées en cellules uniques.

"La dissociation est nécessaire pour imprimer ces

cellules en haute résolution, mais elle induit une mort cellulaire programmée

(bien que cela puisse être retardé par l'ajout de suppléments au milieu de culture)", explique Lothar Koch

de Laser Zentrum Hannover, auteur de l'étude publiée dans Biofabrication .

"Ils sont donc difficiles à imprimer avec des techniques éprouvées telles

que l'extrusion, l'impression par jet d'encre, les techniques d'éjection de

gouttelettes acoustiques, l'écriture directe guidée par laser et la bio

printing au laser."

De plus, poursuit Koch, la pluripotence des cellules et la

différenciation dirigée sont affectées par des facteurs environnementaux, tels

que la composition du milieu de culture dans lequel ils sont cultivés et les

bio encres utilisées pour les imprimer.

Ils sont également sensibles aux forces mécaniques, telles que les contraintes

de cisaillement qui peuvent survenir lors des processus de bio printing

La nouvelle technique d'impression laser développée par Koch

et ses collègues exploite des impulsions laser pour expulser de minuscules

gouttelettes d'une bio encre contenant des hiPSC suspendues à partir d'une fine

couche de bio encre déposée sur une lame de verre. "La principale

différence avec les approches précédentes, telles que l'extrusion ou

l'impression à jet d'encre, est l'absence d'une buse", explique Koch.

"Bien que cela rende la préparation et l'application du bio encrage plus complexe, cela signifie que nous évitons

les forces de cisaillement élevées qui se produisent habituellement dans les

petites buses."

La technique combine l'impression de petites gouttelettes,

jusqu'à quelques volumes de pico litre, avec l'impression de bio encrage à haute viscosité et des densités de cellules

élevées allant jusqu'à 108 cellules par millilitre. "Chacun de ces points

peut être atteint avec d'autres techniques d'impression, mais pas en

combinaison", ajoute Koch.

L'installation de bio encrage au laser comprend le laser et

deux lames de verre. «Nous enduisons la lame supérieure d'une fine couche de

matériaux absorbant le laser», explique Koch. "Il pourrait s'agir d'un

métal biocompatible tel que l'or ou le titane, ou d'un polymère tel que le

triazène ou le polyamide, ou même d'un hydrogel comme la gélatine. Ensuite,

nous déposons le biomatériau à imprimer - généralement un sol contenant des

cellules - en tant que deuxième couche au-dessus de la couche d'absorptio

La lame de verre revêtue est montée à l'envers au-dessus

d'une seconde lame, et des impulsions laser de 10 ns sont ensuite concentrées à

travers la lame supérieure dans la couche d'absorption. «Cela provoque

l'expansion d'une bulle de vapeur et propulse un petit volume de biomatériau

vers la lame de verre inférieure», explique Koch. "En déplaçant le laser

et les lames de verre, nous pouvons imprimer n'importe quel motif 2D et

également générer des motifs 3D couche par couche. Il est également possible de

placer des substrats ou des échafaudages sur la lame de verre inférieure et

d'imprimer le biomatériau directement sur le substrat ou l'échafaudage

Koch a déclaré à Physics World que tous les types de cellules

testés dans ces expériences ont survécu à cette procédure d'impression, avec un

taux de survie de près de 100%. La technique retient également la pluripotente

des cellules et leur permet d'être imprimées dans des modèles hautement

contrôlés pour générer des substituts tissulaires fonctionnels.

Les chercheurs ont testé une variété d'hydrogels comme bio

encres et s de substrats de culture pour

l'impression, et ont trouvé que le fibrinogène, le plasma sanguin, le Matrigel

et l'acide hyaluronique étaient particulièrement appropriés. "L'acide

hyaluronique est naturellement présent dans le corps humain; il est généré au

début de l'embryogenèse et se trouve abondamment dans les environnements de

niche de cellules souches », explique Koch. "Il améliore la prolifération

des cellules souches et soutient la pluripotence aussi. Il est également bon

pour le processus d'impression laser et nous permet d'affiner la viscosité du

bioin

Alors que Koch pense que les hiPSC sont les types de

cellules les plus prometteurs pour l'impression de tissus ou d'organes, il

souligne la nécessité d'étudier le processus plus en détail. "Une question

importante que nous devons nous poser est la suivante: quel stade de

différenciation est optimal pour l'impression? Pour y répondre, nous devons

étudier l'imprimabilité des hiPSC à tous les stades possibles de

différenciation. "

L'équipe dit qu'elle va maintenant développer un bio encrage

plus avancé pour imprimer des structures 3D plus complexes. "Une autre

application intéressante pour l'impression hiPSCs est de les utiliser pour

générer des constructions cellulaires qui imitent les corps embryonnaires pour modéliser le développement humain ou

étudier les maladies », explique Koch. "Nous chercherons à imprimer de

tels modèles d'organoïdes embryonnaires avec notre technique." Lisez notre

collection spéciale "Frontiers in biofabrication" pour en savoir plus

sur les dernières avancées en ingénierie tissulaire. Cet article fait partie

d'une série de rapports soulignant la recherche à fort impact publiée dans la

revue Biopabrication de l'IOP Publishing

. Belle Dumé est rédactrice en chef de Physics World

MON COMMENTAIRE / Je suis très

étonné de voir imprimer ces tissus quasi

humains de cellules pluripotentes

88888888888888888888888888888888888888888888888888888

4

Early universe simulated in a cloud of ultracold atoms

Univers primitif simulé par un nuage d'atomes ultrafroids

27 avril 2018

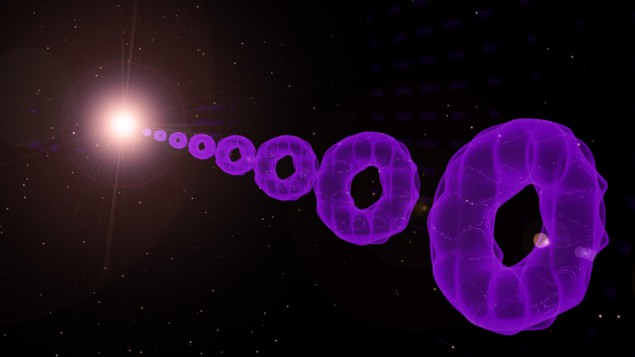

L'univers primitif a été imité en laboratoire en utilisant

un condensat de Bose-Einstein (BEC) en forme d'anneau d'atomes ultrafroids.

Gretchen Campbell, Stephen Eckel et ses collègues du Joint Quantum Institute de

l'Université du Maryland ont augmenté la taille de leur nuage atomique

ultrafroid à une vitesse supersonique et ont observé plusieurs effets associés

à l'époque inflationniste de l'univers primitif. On pense que cette époque

s'est produite moins de 10^-32 secondes après le Big Bang, lorsque l'univers

s'est développé à un rythme exponentiel.

Les condensats de Bose-Einstein (BEC) sont formés lorsque

des atomes identiques avec un spin entier sont refroidis jusqu'à ce que tous

les atomes soient dans le même état quantique à basse énergie. Cela signifie

qu'un BEC comprenant des dizaines de milliers d'atomes se comporte comme une

seule entité quantique. Un BEC peut être considéré comme un état de vide pour les

phonons, qui sont des quanta d'énergie mécanique vibratoire. L'équipe a utilisé

ce vide de phonon comme une analogie pour le vide du champ quantique dans

l'univers primitif.

Dans une expérience, les chercheurs ont introduit une onde

sonore sur leur nuage pour voir comment il a évolué pendant l'expansion. La

longueur d'onde des phonons augmente (ou le redshifts) lorsque l'expansion se produit,

fournissant ainsi une analogie avec la façon dont les photons glissent vers le

rouge dans un univers en expansion. Ils

ont également vu que l'amplitude de l'onde diminue pendant l'expansion.

L'équipe a fait une tentative de connexion entre cet effet et un étrange

phénomène d'amortissement cosmologique appelé " la friction Hubble".

Dans un autre test, l'équipe a élargi le BEC sans ondes

sonores, et l'a vu se stabiliser après avoir atteint son rayon maximum, un état

analogue à la fin de l'époque inflationniste de l'univers. Ici, l'énergie qui

alimentait l'inflation se traduisait rapidement en solitons et tourbillons de

BEC instables, produisant des phonons.

"Nous voyons la création d'excitations d'une manière

qui rappelle le préchauffage et le réchauffement dans l'univers primitif",

expliquent Campbell et Eckel. "Après l'inflation, toute l'énergie de

l'univers était vraisemblablement contenue dans un champ quantique qui

provoquait l'inflation appelée" inflaton ". Ce champ s'est

désintégré, déposant son énergie dans des particules de masse inférieure

provoquant le réchauffement de l'univers (d'où le terme de réchauffement).

"

L'équipe travaille maintenant à l'amélioration de leur

modèle BEC à anneau en expansion afin de mieux observer l'amortissement qu'ils

associent au frottement de Hubble. En regardant vers l'avenir, les physiciens

espèrent générer des paires d'ondes sonores corrélées qui imitent le

rayonnement de Hawking des trous noirs. Ils espèrent également simuler des

horizons cosmologiques en créant des régions déconnectées par hasard dans un

condensat

Silke Weinfurtner, de l'Université de Nottingham, pense que

les expériences sont "magnifiquement exécutées" et "un pas en

avant important dans la réalisation d'expériences sur la pesanteur

analogique en labo ", même s'il

n'est pas convaincu par le réchauffement et le préchauffage. «Dans l'ensemble,

les expériences de cosmologie gravimétrique analogique nous permettent de

tester certaines des expériences fascinantes dans un laboratoire contrôlé»,

ajoute-

Cependant, comme pour les autres expériences de cosmologie

analogique, le principal test sera de découvrir de nouvelles physiques ou de confirmer de nouvelles théories

cosmologiques: "Nous avons déjà beaucoup appris de la cosmologie, mais

nous ne savons pas encore si nous guiderons la cosmologie". Campbell et

Eckel. "Notre espoir est que notre système pourrait fournir un banc

d'essai où nous pourrions réellement étudier de nouveaux modèles et voir ce qui

se passe."

La recherche est décrite dans Physical Review X.

Benjamin Skuse est un écrivain scientifique basé à Bristol,

MON COMMENTAIRE / Cet article

confirme tout l’intérêt qu’ il y a à utiliser les propriétés des BECS pour continuer à défricher leur

implication cosmologique

8888888888888888888888888888888888888888888888888888888888888

5

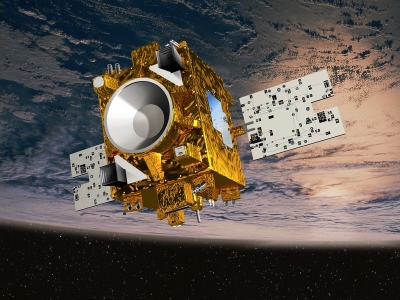

MICROSCOPE

MICROSCOPE concentre des limites plus strictes sur une

cinquième force

17 avril 2018

MICROSCOPE

De nouveaux aperçus

SUR l'existence d'une cinquième force fondamentale hypothétique ont été

recueillis par des physiciens utilisant les données de la mission spatiale

MICROSCOPE lancée en 2016 par le Centre national d'études spatiales (CNES). Le

travail a été réalisé par Joel Bergé à l'Université de Paris Saclay et ses

collègues.

Les théories du tenseur scalaire forment une vaste classe de

théories sur la nature de la gravité et ont des conséquences fascinantes. À la

limite newtonienne - c’est à dire pour

les petites masses et champs gravitationnels faibles - les théories

scalaires-tenseurs impliquent une cinquième force fondamentale. Cette force

peut être décrite en utilisant une modification des lois gravitationnelles de

Newton impliquant un potentiel de Yukawa. Le potentiel révèle comment la portée

de la cinquième force dépend de la masse du champ scalaire - et la gamme peut

varier du micron jusqu'aux échelles cosmologiques.

Une telle cinquième force devrait conduire à la violation du

principe d'équivalence faible (WEP), qui stipule que tous les corps de test tombent avec la même accélération

indépendamment de leur structure interne ou de leur composition. En revanche,

le potentiel de Yukawa fait varier la cinquième force en fonction de la

composition des masses concernées - ce qui devrait conduire à des accélérations

différentes pour différents types d'ob

Dans leur étude, l'équipe a cherché à mesurer les effets de

cette dépendance sur la composition pour mettre des contraintes sur les forces

des interactions de type Yukawa. Ils examinent également comment le potentiel

de Yukawa implique des variations dans les constantes physiques fondamentales

qui pourraient régir la violation du WEP, leur permettant d'établir des

contraintes sur ces variations.

L'expérience MICROSCOPE du CNES a été lancée en 2016 et a

livré ses premières données. Le satellite teste la différence possible dans les

taux de chute libre de deux masses d'essai fabriquées à partir de matériaux

différents lorsqu'elles sont en orbite autour de la Terre - détectant ainsi la

violation de WEP potentielle. L'équipement mesure la différence d'accélération entre

les masses dans le même champ gravitationnel, à une précision d'une partie en

10^14. Aucune différence n'a été trouvée, et donc il n'y a pas de preuve d'une

cinquième force à ce niveau de précision.

Les chercheurs ont également exploré ce que cette contrainte

dit sur les causes physiques potentielles d'une cinquième force hypothétique.

Ils ont fait valoir que les champs scalaires massifs sont couplés soit aux

nombres de baryons, soit à la différence entre les nombres de baryons et de

leptons des particules constitutives de la matière. L'idée a permis à l'équipe

d'améliorer les contraintes existantes sur la cinquième force pour des

distances supérieures à 10^5 mètres en ordre

de grandeur.

Après la fin de l'expérience MICROSCOPE plus tard dans cette année, l'équipe de Bergé aura accès

à 10 fois plus de données que celles utilisées pour faire ses calculs.

L'information permettra aux chercheurs d'optimiser leurs contraintes sur la

violation de WEP et la cinquième force ou encore plus loin.

L'étude est décrite dans Physical Review Letters.

Sam Jarman est un écrivain scientifique basé au Royaume-

MON COMMENTAIRE/'interaction de Yukawa peut être utilisée pour décrire la

force nucléaire entre les nucléons (qui sont des fermions), médiée par des

pions (qui sont des mésons pseudoscalaires) Pour l instant ; la 5 ème

force ne se fait pas trop voir avec

MICROSCOPE !1 kg de plumes =1 kg de plomb !

88888888888888888888888888888888888888888888888888888888

GRAVITY BLOG

GW170817 kilonova: que s'est-il passé ensuite

15 avril 2018 Hamish Johnston

g

Le point culminant de la physique de 2017 - et notre percée

de l'année - a été la toute première observation d'astronomie multi messenger

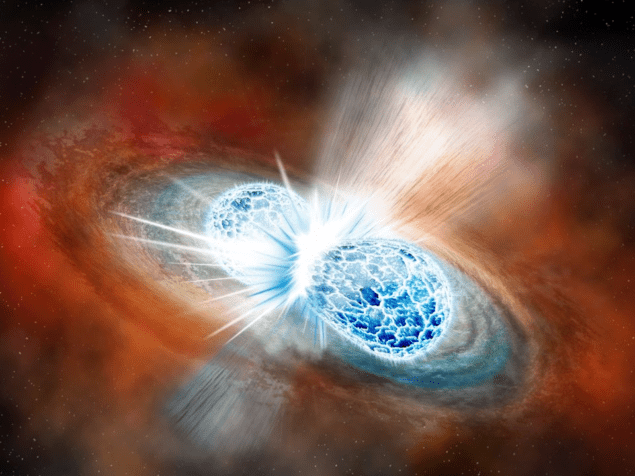

impliquant la détection d'ondes gravitationnelles. Ce fut la fusion

spectaculaire de deux étoiles à neutrons dans une explosion de kilonova

baptisée GW170817, qui a été étudiée à travers le spectre électromagnétique des

rayons gamma jusq’aux ondes radio.

Les premiers signaux de la kilonova ont été vus en août

2017, mais les astronomes en apprennent toujours plus sur la fusion et ce

qu'elle a créé - probablement un trou noir qui produit un jet astrophysique.

Les astronomes sont particulièrement intéressés à en

apprendre davantage sur ce jet. Aujourd'hui, lors de la réunion d'avril de

l'American Physical Society à Columbus, en Ohio, Eric Burns de la NASA a fait

le point sur ce que le signal gamma nous dit à propos de la kilonova.

GW170817 a émis un éclair de rayons gamma qui, selon Burns,

ressemble à une «courte explosion de rayons gamma». Cependant, il était environ

10-100 fois plus faible que la plupart des autres courtes rafales observées. Ce

pourrait être parce que nous regardons le bord du jet ou que le jet n'est pas

uniforme - le jury est toujours en discussi

Les ondes gravitationnelles de la fusion ont d'abord été

détectées par LIGO-Virgo, puis environ 1,7 s plus tard, les premiers rayons

gamma ont été vus par le satellite Fermi. Pourquoi le retard entre les deux

signaux? Il est possible qu'une partie de ce retard soit associée à une étoile

à neutrons hypermassive qui existait brièvement avant de s'effondrer dans un

trou noir. Une telle étoile à neutrons émettrait des ondes gravitationnelles, mais

elles ne peuvent être détectées par LIGO-Virgo. Un autre facteur contribuant au

retard est le temps nécessaire à la formation du jet avant qu'il ne commence à

émettre des rayons gamma.

La nature précise du jet a fait l'objet d'une conférence de Gregg

Hallinan, de Caltech, qui a passé en revue les observations radio de GW170817.

Les ondes radio sont produites lorsque le jet se dilate et se refroidit.

Premièrement, il y a une augmentation de la quantité d'ondes radio produites,

suivie d'une baisse attendue après environ 100 jours. Hallinan a expliqué que

la nature précise de la façon dont cette baisse se produit fournit des indices importants

sur la nature du jet

En utilisant les observations faites jusqu'ici, Hallinan et

ses collègues estiment que la sortie radio est cohérente avec un grand-angle,

un écoulement légèrement relativiste que nous observons le long de l'axe de

rotation du trou noir.

La dernière discussion de la session a été faite par Tony

Piro de l'Observatoire Carnegie, qui faisait partie de l'équipe qui utilisait

des télescopes optiques pour localiser GW170817. Il a montré des mesures du

spectre visible de la kilonova, qui peut être ajusté à une courbe de corps noir

pour donner la température de l'écoulement. La première mesure a révélé une

température de 11 000 K, mais celle-ci a rapidement chuté à 9500 K en une heure

seulement. Connaître le taux de refroidissement a permis à l'équipe de calculer

la vitesse de la sortie, qui compte pour environ 30% de la vitesse de la

lumière.

LIGO-Virgo est actuellement en cours de modernisation et les

détecteurs reviendront en ligne plus tard cette année pour leur troisième

passage d'observation. Burns estime qu'environ une fusion d'étoiles à neutrons

par an peut être observée à la fois avec les ondes gravitationnelles et les

rayons gamma, ce qui permet de mieux comprendre ce phénomène fascinant.

Hamish Johnston est l'éditeur de physique générale de

Physics World

MON COMMENTAIRE / le

développement des études sur les ondes gravitationnelles deviendra passionnant s il permet de s’attaquer à des secousses du

tissu de l’espace-temps plus faibles que celle de fusions de gros trous noirs

88888888888888888888888888888888888888888888888888888888888

7

GRAVITY BLOG

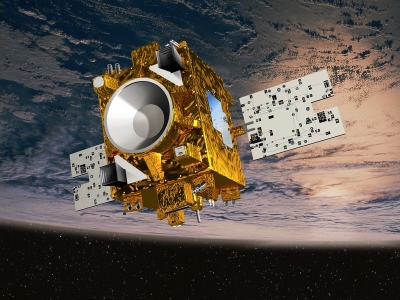

Métal lourd pour détecter les ondes gravitationnelles

Heavy metal for detecting gravitational waves

16 avril 2018 Hamish Johnston

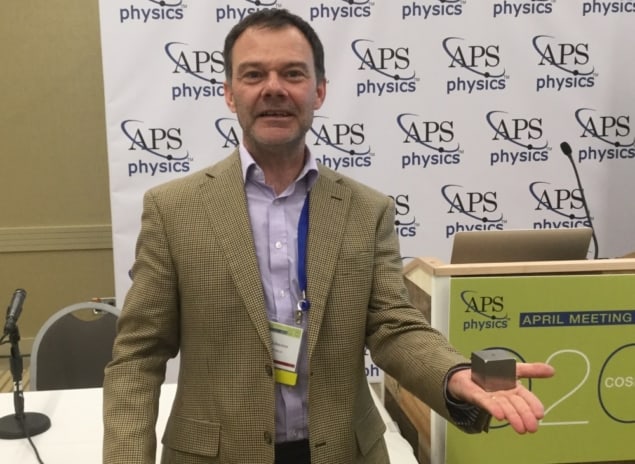

Emettons des suppositions sur ce que je tiens dans ma main?

C'est métallique et très lourd.

Si vous avez deviné une réplique en tungstène d'une masse

d'essai LISA, vous avez raison.

Les masses d'essai réelles sont faites d'or et de platine,

selon John Baker de la NASA qui a apporté la réplique à la réunion d'avril de

l'American Physical Society ici à Columbus, Ohio.

Ce matin, Baker a donné une mise à jour sur le statut de la

mission spatiale LISA, qui consiste à placer trois de ces masses dans trois

vaisseaux spatiaux en orbite autour du Soleil - espérons-le d'ici 2034.

Les positions relatives des masses seront surveillées en

échangeant de la lumière laser entre les vaisseaux spatiaux. Il est prévu

d'utiliser la configuration pour détecter les ondes gravitationnelles provenant

d'objets beaucoup plus grands que ce qui est actuellement possible en utilisant

les détecteurs LIGO-Virgo au sol.

Contrairement à beaucoup de grands projets scientifiques,

LISA est en avance sur le calendrier - du moins pour prouver qu'il est

réellement possible de le faire fonctionner. En 2016, les scientifiques

travaillant sur la mission spatiale LISA Pathfinder ont pu isoler une masse

d'essai de 2 kg du bruit d'accélération à un «point lagrangien» spécial entre

la Terre et le Soleil. Ce fut un exercice de preuve de principe qui a non

seulement réussi à atteindre son objectif préliminaire, mais qui a également

répondu aux exigences réelles de la mission LISA beaucoup plus tôt que prévu.

Puis, environ un an plus tard, les scientifiques ont montré que la masse peut

également être isolée des interférences liées à l'accumulation d'électricité statique.

Baker dit que le prochain test de preuve de principe

implique de montrer qu'il sera possible d'utiliser des lasers pour mesurer les

positions relatives de l'engin spatial. Cela se fera très prochainement avec

l'engin spatial GRACE-FO, qui sera lancé le mois prochain. Les deux engins

spatiaux seront espacés de 220 km lorsqu'ils seront en orbite autour de la

Terre et la séparation entre eux sera surveillée attentivement pour révéler les

fluctuations liées aux changements du champ gravitationnel local de la Terre.

Cette information peut ensuite être utilisée pour surveiller l'épaisseur des

calottes glaciaires ou même calculer la quantité d'eau dans les lacs, les

rivières ou même sous terre.

FO signifie "follow on" de la mission originale de

GRACE, qui a fonctionné pendant 15 ans avant de se terminer l'année dernière.

Ce qui est nouveau à propos de GRACE-FO est qu'il inclura un système de

télémétrie laser similaire à celui qui sera utilisé dans LISA. Espérons que ces

tests seront couronnés de succès et que LISA ira de l'avant comme prévu. En

effet, la raison principale pour laquelle le lancement est prévu pour 2034,

plutôt que plus tôt, est que l'ESA et ses agences partenaires (y compris la

NASA) n'ont tout simplement pas le budget pour le lancer plus tôt. Peut-être qu'il y a un

autre pays avec des poches profondes et

pleinesqui pourraient aider.

Hamish Johnston est l'éditeur de physique générale de

Physics World

MON COMMENTAIRE / PAS DE BUDGET ???? Alors bon courage !

8888888888888888888888888888888888888888888888888888a suivre

Aucun commentaire:

Enregistrer un commentaire