Comment mesurer le comportement quantique dans les

nanocristaux

How to measure quantum behaviour in nanocrystals

11 juin 2018

Oscillateur quantique

Oscillations harmoniques : quelle peut être la taille d'un

objet quantique? (Gracieuseté: iStock / Swillklitch)

Une nouvelle expérience qui teste la limite de la taille

d'un objet avant qu'il cesse de se comporter mécaniquement sous structure quantique a été proposée par des physiciens

britanniques et indiens. La mesure consiste à piéger un nanocristal avec de la

lumière, puis à mesurer sa position pour voir si son comportement viole

l'inégalité de Leggett-Garg - qui est un test de la nature quantique d'un

système. Alors que l'équipe souhaite que sa proposition soit testée en

laboratoire, tous les physiciens ne pensent pas qu'elle puisse être mise en

œuvre.

Le principe d'incertitude de Heisenberg est une

caractéristique importante de la mécanique quantique. Alors que dans la

mécanique classique, la position et la quantité d'un objet peuvent être

déterminées avec une précision arbitrairement élevée, le principe de Heidelberg

stipule qu'il est impossible de mesurer la position et le moment en mécanique quantique au-delà d'un certain

degré de précision. De plus, plus vous en savez sur une mesure, plus

l'incertitude devient grande.

L'expérience proposée teste la taille d'un objet avant que

les règles de mesure quantique ne s'appliquent. Sougato Bose de l'University

College London et ses collègues de l'Institut Bose et du Centre national des

sciences fondamentales de SN Bose à Calcutta ont étudié le comportement d'un

oscillateur harmonique linéaire quantique, lequel ressemble fortement à son

homologue classique. "Les incertitudes sur la position et le moment sont

toutes deux aussi faibles qu'elles peuvent l'être", explique Bose.

Bose et ses collègues ont fait une analyse d'une expérience

hypothétique impliquant un nanocristal refroidi oscillant dans un piège créé

par un potentiel harmonique optique. L'expérience permet de détecter à tout

moment quel côté du piège est occupé par le nanocristal en focalisant un faisceau

de lumière sur un côté du piège. La

lumière provoque la fluorescence dans le nanocristal, et si la lumière

fluorescente n'est pas détectée, on peut conclure que le nanocristal est dans

l'autre côté du piège - une procédure appelée mesure de résultat négatif.

L'expérience commence par une mesure de position, puis le

système évolue pendant environ une microseconde avant que la position ne soit à

nouveau mesurée. Si le nanocristal est un objet purement classique, les

chercheurs ont raisonné qu’ un résultat négatif dans la première mesure

n'affecterait pas la position du nanocristal dans la seconde mesure. C'est

parce que le nanocristal aurait été dans l'autre moitié du piège, et n'aurait

donc pas interagi avec le faisceau. Cependant, s'il existait une incertitude

quantique dans la position et l'impulsion du nanocristal, le résultat nul au

début de l'essai expérimental pourrait encore affecter sa position mesurée lors

de la seconde mesure. C'est parce que la position du nanocristal ne serait pas

bien définie avant d'être réellement mesurée. Par conséquent, le nanocristal

pourrait avoir interagi avec le faisceau lumineux dans la moitié du piège, même

s'il n'y a pas été détecté.

L'équipe a calculé l'inégalité Leggett-Garg pour les

systèmes. Ceci est analogue à l'inégalité de Bell, qui est célèbre pour exclure

les explications de variables cachées de

la mécanique quantique. L'inégalité de Bell quantifie la corrélation

statistique maximale possible entre les propriétés de particules indépendantes

séparées par des distances si grandes que l'information ne peut pas passer

entre elles sans se déplacer plus vite que la lumière.

L'inégalité de Leggett-Garg utilise un raisonnement

similaire pour calculer la corrélation statistique maximale entre deux

résultats qui ne s'étaient pas influencés l'un l'autre. La violation de

l'inégalité, par conséquent, montrerait que l'état du nanocristal pourrait être

influencé par le résultat négatif antérieur, et donc que le nanocristal est un

objet quantique plutôt que classique. En calculant les valeurs , les chercheurs

ont calculé qu'il devrait être possible de détecter un comportement non

classique pour des objets ayant des

masses allant jusqu'à environ 10^10 amu ou environ 10^-14 g. Bose dit que les

expérimentalistes prévoient de tester cela.

Bose et ses collègues rapportent leurs résultats dans

Physical Review Letters. Le physicien théoricien Clive Emary, de l'Université

de Newcastle au Royaume-Uni, a déclaré: "Si quelqu'un fait ces

expériences, nous regarderons en arrière et nous dirons que c'était un travail

important". Il avertit cependant: "il

me semble qu'il y a besoin

d’une très haute résolution temporelle

pour faire les mesures proposées et, d'après mon expérience, cela ressemble à

ce que vous proposez a des expérimentateurs ^pour qu’ ils reviennent en disant"

c'est assez difficile ". Le théoricien de l'information quantique Renato

Renner de l'ETH Zurich est plus optimiste: "Nous pouvons maintenant faire

des expériences sur les technologies quantiques qu'il aurait été impossible de

réaliser il y a cinq ou dix ans", dit-il. nous pouvons penser à vouloir qu’ à un certain moment ce soit

réalisable. "

Emary et Renner sont d'accord, cependant, que, dans

l'inégalité de Bell, les deux mesures sont isolées classiquement par le fait

que rien ne peut voyager plus vite que la vitesse de la lumière, l'inégalité de

Leggett-Garg repose sur la preuve qu'il ne peut y avoir d'explication classique

à la mesure antérieure perturbant la suivante

. "Ce n'est tout simplement pas possible", dit

Emary, "Il y a toujours une faille: vous pourriez déranger les molécules

d'air dans le laboratoire d'à côté et elles pourraient revenir et perturber

votre système, par exemple."

TIM WOGAN/PHYSICS

WORLD

MON COMMENTAIRE / Cet article n’est pour moi (et encore une

fois de plus dans PHYSICS WORLD) qu’ une

expérience de pensée poursuivie par l’étude mathématique sur nanocristal inhérente à l’incertitude de

HEISENBERG ….Mais je reconnais qu’ il peut être intéressant pour un philosophe de préciser la limite à partir de laquelle un

objet peut être classé comme « classique » ou comme quantique …

et en particulier savoir quand et

comment les phénomènes quantiques « débarquent » à notre échelle

humaine et macroscopique …… J’avoue que la remarque finale de Emary sur

cette sorte d’effet papillon

provoqué par la décohérence et l’environnement a de quoi décourager les expérimentateurs….. Tous

les objets décrits par la physique classique (pomme de Newton , planète, chat,

etc.) étant composés, ultimement , d'atomes et de particules, et ces derniers

étant décrits entièrement( ?) par la physique quantique, il serait logique

de considérer que les règles de la physique classique puissent se déduire de

celles de la physique quantique. Or, les tentatives en ce sens ont posé des

problèmes au départ et pendant longtemps. La théorie de la décohérence de H. Dieter Zeh ( mort récemment)est à ce jour une des

tentatives les plus satisfaisantes en ce sens, bien que non entièrement aboutie

……

88888888888888888888888888888888888888888888888888

L'apprentissage automatique révèle les phases quantiques de

la matière

Machine learning reveals quantum phases of matter

12 juin 2018

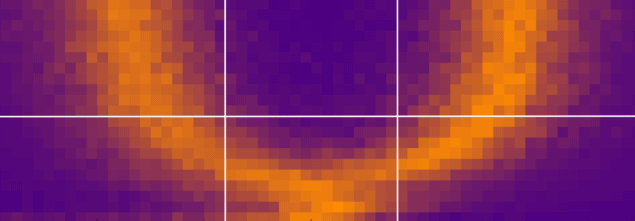

Apprentissage automatique

Limite de phase: deux phases de localisation du corps (bleu)

sont clairement séparées par une zone limite orange. (Courtoisie: Eun-Ah Kim)

Des physiciens aux États-Unis ont utilisé l'apprentissage

automatique pour déterminer le diagramme de phase d'un système de 12 particules

quantiques idéalisées à une précision plus élevée que jamais auparavant. Le

travail a été fait par Eun-Ah Kim de l'Université Cornell et ses collègues qui

disent qu'ils sont probablement les premiers à utiliser des algorithmes

d'apprentissage automatique pour découvrir "l'information au-delà des connaissances

conventionnelles" sur la physique

de la matière condensée

Jusqu'ici, l'apprentissage automatique n'a été utilisé que

pour confirmer des résultats condensés dans des démonstrations de principe, explique Roger Melko, de

l'Université de Waterloo au Canada, qui n'a pas participé au travail. Par

exemple, Melko a utilisé l'apprentissage automatique pour trier divers états

magnétiques de la matière qui avaient déjà été classés auparavant. Au lieu de

cela, Kim et ses collègues ont fait de nouvelles prédictions sur les phases de

leur système qui sont inaccessibles avec d'autres méthodes. "Ceci est un

exemple de machines qui ont déjà été utilisées par des humains", explique

Melko.

Le groupe de Kim a étudié la physique de 12 électrons

idéalisés interagissant selon le modèle d'Ising - qui décrit l'interaction

entre les spins des particules voisines. Bien que leur modèle à 12 particules

soit simpliste par rapport aux matériaux de la vie réelle, ce système peut à

peine être simulé par les supercalculateurs. C'est parce que la complexité des

simulations quantiques croît exponentiellement avec chaque particule

supplémentaire.

L'équipe était particulièrement intéressée à comprendre les

nombreuses phases de localisation de

corps (MBL) qui peuvent survenir dans

les systèmes quantiques. Ces phases se produisent lorsque les particules sont

en déséquilibre et ne se comportent pas comme une collection de particules

non-interactives ni comme un ensemble. Les physiciens ont du mal à décrire les

phases MBL parce que les concepts statistiques tels que la température et la

pression sont mal définis. "Ils défient notre compréhension de la

mécanique statistique quantique et du chaos quantique", explique Kim.

L'équipe a élaboré l'algorithme d'apprentissage automatique pour

dessiner un diagramme de phase qui comprend deux phases MBL différentes et une

phase conventionnelle. Pour ce faire, ils ont d'abord généré des données

simulées de différentes configurations des 12 particules quantiques

correspondant à des phases connues. Ils ont alimenté chaque configuration à un

réseau de neurones, qui a classé les données dans une phase particulière. À ce

stade du processus d'apprentissage automatique, les chercheurs ont dit au

réseau de neurones si sa classification était correcte. Compte tenu de cette

rétroaction, le réseau de neurones a développé de manière itérative un

algorithme basé sur la multiplication matricielle qui pourrait distinguer entre

les phases. Le réseau de neurones peut atteindre une précision de

classification de 90% après avoir été entraîné avec 1000 configurations de

particules différentes.

L'étape suivante consistait à utiliser le réseau de neurones

pour classer les configurations de particules de phase inconnue. En triant ces

configurations, ils pourraient remplir un diagramme de phase avec des limites

plus distinctes par rapport aux diagrammes antérieurs réalisés à partir

d'autres techniques

Un inconvénient important de l'utilisation des réseaux de

neurones pour prédire cette nouvelle

physique est que nous n'avons pas une compréhension claire de la façon dont les

systèmes apprennent. C'est un vaste domaine de la recherche actuelle connu sous

le nom de problème d'interprétabilité. Heureusement, le réseau de neurones de

Kim est relativement simple. De nombreux réseaux neuronaux, tels que ceux qui

alimentent les algorithmes de reconnaissance de la parole et de l'image,

impliquent d'alimenter les données d'entrée par de multiples itérations de

multiplication matricielle appelées «couches cachées» avant qu'elles ne

produisent une sortie. Ces couches cachées sont les parties les plus opaques du

processus d'apprentissage, et le réseau neuronal de Kim n'a qu'une couche

cachée. Son groupe essaie maintenant de distinguer ce que fait exactement ce

calque caché. «Il est possible de regarder à l'intérieur d'un réseau de

neurones simple et personnalisé et de comprendre comment il prend ses

décisions», explique Kim.

En outre, Kim veut voir si l'équipe peut appliquer un type d'apprentissage

machine plus sophistiqué, connu sous le nom d'apprentissage non supervisé, à

des problèmes de matière condensée. Contrairement à l'apprentissage supervisé,

où l'algorithme reçoit la réponse correcte en retour, un algorithme

d'apprentissage non supervisé ne reçoit pas ce type de retour.

Les problèmes de matière condensée sont particulièrement

bien adaptés à l'apprentissage automatique, car ils impliquent de nombreuses

particules en interaction, et donc beaucoup de données, dit Melko. Le champ

évolue vite, dit-il. "Tout comme vous prenez votre téléphone et tenez pour

acquis que Siri ( le réseau) fonctionne,

dans quelques années, je pense que tout le monde va prendre pour acquis qu'il y

aura une certaine intégration de la technologie AI dans ces expériences quantiques

très complexes", dit-il.

Un papier decrit la recherche dans Physical Review Letters avec un

preprint sur arXiv.

Sophia

Chen est freelance science writer in

Tucson, Arizona

MON COMMENTAIRE / Nous voilà maintenant avec l’entrée dans PHYSICS WORLD et les articles de ses auteurs en contact avec un concept nouveau , l « 'apprentissage profond » (en anglais deep learning,) et son corollaire le réseau neuronal artificiel, Tous les média en parlent ! Alors pourquoi ne pas en parler ici ?! Pour mettre au courant mes lecteurs je vous présente deux photos vous résumant mieux que du texte les concepts…

Vue simplifiée d'un réseau artificiel de neurones

réseau de neurones convolutifs (CNN) est une méthode d'apprentissage automatique reposant sur l'apprentissage profond.

Les techniques

d'apprentissage profond utilisent la capacité d’un ordinateur à reconnaître et

classer diverses représentations à force de les lui montrer de très nombreuses

fois !!!! Plus précisément elles permettent de conférer du « sens » à des données en leur

donnant la forme d’images, de sons ou de textes. , Il s’agit d’ architectures constituées

par une classe d’algorithmes

d'apprentissage automatique Elles reposent sur l’utilisation de réseaux de neurones artificiels à multicouches issus eux-mêmes du

concept de perception neurologique .Ils

sont ensuite relayés par des machines qui permettent de traiter des données massives. Donc ,

pourquoi pas ,après les GAFA (Google,

Apple, Facebook, Amazon ) ne pas s’intéresser

aux collections multi quantiques , me direz-vous ???

En fait cet article sur 12 « objets quantiques idéaux » est un exercice de style et qui n’a rien de

réel !!!.

Vue simplifiée d'un réseau artificiel de neurones

88888888888888888888888888888888888888888888888

3

Universal migration predicts human movements under climate change

La migration universelle prédit les mouvements humains sous

le changement climatique

12 juin 2018

Photo de bateau de pêche, personne et plage au

Bangladesh. Courtoisie: par Saiful Islam - Travail personnel, CC BY-SA 4.0,

https://commons.wikimedia.org/w/index.php?curid=35668254

Courtoisie: Saiful Islam - CC BY-SA 4.0,

https://commons.wikimedia.org/w/index.php?curid=35668254

On s'attend à ce que le changement climatique déplace des

millions de personnes à travers des impacts tels que l'élévation du niveau de

la mer, les mauvaises récoltes et des conditions météorologiques extrêmes plus

fréquentes. Pourtant, les scientifiques ne peuvent toujours pas prédire où ces

migrants induits par le climat sont susceptibles d'aller dans les prochaines

décennies.

Une nouvelle étude, publiée aujourd'hui dans Environmental

Research Letters, cherche à répondre à ce besoin en intégrant les impacts

climatiques dans un modèle universel de mobilité humaine.

Pour démontrer l'efficacité de la nouvelle approche, l'étude

s'est concentrée sur le cas de l'élévation du niveau de la mer et des

migrations humaines au Bangladesh, où les auteurs estiment que plus de deux

millions de Bangladais pourraient être déplacés du fait de la variation des niveaux seuls

L'étude, menée par l'Université de Columbia, à New York, a

utilisé un modèle probabiliste combiné à des données démographiques,

géographiques et climatiques pour prédire les sources, les destinations et les

flux de migrants potentiels causés par l'élévation du niveau de la mer.

L'auteur principal, le Dr Kyle Davis, de l'Université de

Columbia, a expliqué: «Plus de 40% de la population du Bangladesh est

particulièrement vulnérable à l'élévation du niveau de la mer, car ils vivent

dans des zones basses souvent exposées à des phénomènes naturels extrêmes.

"Cependant, SLR est un type de moteur de migration très

différent des aléas naturels de courte durée, en ce sens qu'il rend certaines

zones définitivement inhabitables."

Les résultats de l'équipe utilisant des scénarios

représentatifs de la trajectoire de concentration (RCP) ont montré que la SLR

moyenne entraînerait des déplacements de population dans 33% des districts du

Bangladesh et 53% dans des conditions plus intensives. Au milieu du siècle, ils

estiment que près de 900 000 personnes migreraient probablement à cause de

l'inondation directe due à la seule SLR.

Dans le scénario le plus extrême, jusqu'à 2 mètres de SLR

moyen, le nombre de migrants entraînés par une inondation directe pourrait

atteindre 2,1 millions de personnes en l'an 2100. Pour tous les scénarios du

PCR, cinq districts - Barisal, Chandpur, Munshiganj, Narayanganj et Shariatpur

- sont la source de 59% de tous les migrants.

Leur analyse a pris en compte la SLR moyenne sans marées

hautes normales, de sorte que les résultats - à la fois en termes de zone

inondée et de population déplacée - sont conservateurs.

Les chercheurs ont également estimé les emplois

supplémentaires, le logement et la nourriture nécessaires pour accueillir ces

migrants à leurs destinations. Ils ont constaté que pour faire face au nombre

de personnes susceptibles d'être déplacées d'ici 2050, 600 000 emplois

supplémentaires, 200 000 résidences et 784 milliards de calories alimentaires

seront nécessaires.

Ces résultats ont des implications claires pour les lieux

susceptibles d'accueillir des migrants entrants.

Davis a déclaré: «Les migrants SLR ne chercheront

probablement pas loin d'un endroit attrayant pour se déplacer, et la

destination sera généralement un compromis entre les opportunités d'emploi, son

éloignement de l'origine des migrants et sa vulnérabilité à la SLR elle-même.

"Nous avons constaté que la ville de Dhaka était

constamment favorisée, devenant la destination principale dans tous les

scénarios. Cela signifie que la ville devra se préparer au plus grand nombre de

migrants, ce qui pourrait aggraver la croissance urbaine déjà rapide de la

région. "

L'étude a également identifié d'autres risques de la SLR,

notamment sur les moyens de subsistance et la sécurité alimentaire.

Davis a expliqué: "L'inondation par la mer, et

l'émigration qu'elle provoque, auront des effets significatifs sur

l'agriculture et l'aquaculture. Par exemple, 1000 km2 des terres cultivées du

Bangladesh pourraient être sous-marines d'ici la fin du siècle, avec une

superficie encore plus grande rendue inutilisable par l'intrusion d'eau salée.

Étant donné que 48 pour cent de la main-d'œuvre travaille dans l'agriculture,

l'impact serait ressenti en termes d'emplois et de sécurité alimentaire.

"De même, une grande partie de l'aquaculture côtière du

pays est vulnérable aux impacts du changement climatique, ce qui aura

probablement des conséquences nutritionnelles et économiques importantes, étant

donné que 58% des protéines animales du régime bangladais proviennent des

produits de la mer. cinquième producteur aquacole mondial.

«En fin de compte, nous espérons que l'outil de modélisation

que nous avons développé pourra être utilisé par les chercheurs et les

planificateurs pour prédire avec précision la relocalisation des migrants

induits par le climat et permettre le développement de stratégies politiques et

économiques pour relever les défis

Simon Davies est responsable des relations publiques chez

IOP Publishin

MON COMMENTAIRE /Il est interessant

que les météorologues , les physiciens

et les statisticiens commencent à

travailler sur des exemples de migration

où un paramètre précis peut être suivi …Compte tenu de l’ampleur des problèmes que

poseront l’évolution du climat, la

démographie humaine , les problèmes sociaux et économiques conséquents , les guerres

engendrées , la diminution des ressources et les réactions des contrées de réception je

prédis de nombreux articles pour PHYSICS WORLD

dans les décades à venir ….MAIS JE N’Y SERAI PLUS !

88888888888888888888888888888888888888888888888888888888888888

Bonjour Olivier ! Sur la question du seuil de décohérence, voici ma position :

RépondreSupprimera) statistiquement une entité (atomes groupés) suffisamment massique est quantiquement influencée dans toutes les directions. De ce fait, elle est aux limites du seuil du statut macroscopique car les effets quantiques s'annulent.

b) L'entité de base est matérialisée par le proton (10^-27 kg).

c) le taux de couplage avec le niveau subquantique est relatif à xi = 10^11. Au delà il y a saturation. Je serais donc proche des prévisions de l'article annonçant un seuil de décohérence se situant vers une masse de 10^-16 kg (10^-13 g).

Bien à vous.

J'ai vu une coquille cher Olivier (je ne suis pas le seul à en faire) il s'agit de l'incertitude de HEISENBERG et non pas HEIDELBERG !

RépondreSupprimerSelon le modèle OSCAR,

http://www.cosmologie-oscar.com/index.php

si cette incertitude est relative aujourd'hui à la constante de Planck, ce n'était pas le cas avant la constitution du BEC primordial. L'incertitude était alors totalement aléatoire car commandée par l'aléa lié à la source physique de l'impulsion de DIRAC dans les oscillateurs dipolaires stochastiques.

merci dominique : j ai publié jadis des choses à l univ de heidelberg

Supprimerle passé m obsede sans le savoir !!!!!

....et je rajoute inlassablement que le h de Planck n'est que le reflet des paramètres de l'électron dont l'ancêtre est un composant des oscillateurs synchronisés formant BEC.

RépondreSupprimerh = me lambda² / te

Bonjour Olivier.

RépondreSupprimerPuis-je revenir un moment sur la question des neutrinos / antineutrinos ?

Savez-vous comment on parvient à déterminer l'orientation de leur spin et donc de leur chiralité, dans la mesure où ils n'ont pratiquement pas de masse, ni de charge, et qu'ils interagissent difficilement avec le reste de la matière ?

Quel type d'expérience permet de déterminer cela ?

CHER JEAN MARC

RépondreSupprimersi vous savez faire une biblio historique sur internet vous saurez les détails car il est apparu que les neutrinos qui sortaient des rep étaient en fait des antineutrinos ;;; la mise en évidence est relativement récente... et date je crois des manips et calculs japonais sur KAMIOKANDE

Je vous donne la reponse de Nathan Meyer dont ce fut la these mais en anglais QUE J ESPERE VOUS TRADUISEZ :" when the neutrino interacts via a charged current interaction. The charged lepton partner of the neutrino (electron, muon, or tau particle) is produced. If the neutrino is an anti-neutrion then the corresponding anti-particle partner is produced.

RépondreSupprimerIt is possible to differentiate between the 3 charged lepton flavors and their anti-particle using the different masses and charges of the leptons.

Merci d'avoir répondu ! Je reste émerveillé qu'un objet aussi ténu et aussi évanescent puisse être ainsi étudié et identifié ...

RépondreSupprimer